Vergleichstests mit Aufgabenrandomisierung durchführen

So vermeidest du Reihenfolgeeffekte bei Variantenvergleich und Wettbewerbervergleich

Was du bei Vergleichstests mit RapidUsertests beachten musst, z.B. bei der Formulierung der Aufgaben und wie du Reihenfolgeneffekte vermeiden kannst, erklären wir dir hier.

Wann lohnen sich Vergleichstests?

-

Designvergleich: Du hast mehrere Entwürfe einer Webseite, eines Flyers, einer Verpackung oder ähnlichem? Lass deine Tester erklären, was sie anspricht und was ihnen negativ auffällt. Für welche Variante würden sie sich entscheiden und warum?

-

Variantenvergleich: Du möchtest mehrere Featurevarianten miteinander vergleichen? Lass Nutzer deiner Zielgruppe z.B. verschiedene Navigations- oder Filterdarstellungen testen.

-

Wettbewerbervergleich: Willst du wissen, wie deine Wettbewerber auf deine Zielgruppe wirken und was du vielleicht sogar von ihnen lernen kannst? Schicke deine Tester auf die Webseiten deiner Wettbewerber und lass sie ihren Eindruck schildern. Lies auch unsere Best-Practices zu Wettbewerberanalysen.

- Zielgruppenvergleich: Wie nehmen unterschiedliche Zielgruppen die gleiche Website wahr oder wie gehen sie mit den gleichen Aufgaben um? Bei der Testerstellung kannst du verschiedene Zielgruppen anlegen, die alle die gleichen Aufgaben bekommen.

Within-Group vs. Between-Group

Mit RapidUsertests kannst du sowohl Within-Group-Tests (jeder Teilnehmer testet jede Variante bzw. Website) als auch Between-Group bzw. Split-Tests (die verschiedenen Varianten/Websites werden von unterschiedlichen Teilnehmern getestet).

-

Between-Group: Erstelle einen Test für die erste Variante und kopiere diesen, indem du in deinem Dashboard bei „Dein Testkonzept“ auf „ähnlichen Test erstellen“ klickst. Nun kannst du im neuen Test die Reihenfolge der Fragen per Drag-and-Drop anpassen.

-

Within-Group: Erstelle einen Test, bei dem du für jede Variante eine Aufgabe verwendest. Nutze das Randomisierungsfeature, um Reihenfolgeeffekte zu vermeiden.

Was sind Reihenfolgeeffekte?

Die Reihenfolge von Fragen in Fragebögen kann die Bewertung der Teilnehmer beeinflussen, denn vor allem die ersten und letzten Antworten bleiben uns am besten im Gedächtnis. Für deinen Vergleichstest bedeutet das: Wenn du drei Varianten miteinander vergleichst, ohne die Reihenfolge zwischen den Testern zu ändern, würden sich die Tester vermutlich eher für die erste oder die letzte Variante aussprechen.

Reihenfolgeeffekte vermeiden mit unserem Randomisierungs-Feature

Mit unserem Randomisierungs-Feature kannst du bestimmen, welche der Aufgaben den Testern in zufälliger Reihenfolge angezeigt werden sollen. Schickst du sie zum Beispiel in Aufgaben 2-4 auf die unterschiedlichen Webseiten, wählst du einfach diese Aufgaben aus und wir zeigen sie den Testern in unterschiedlichen Reihenfolgen. So erzielst du bei Vergleichstests valide Ergebnisse.

So geht’s

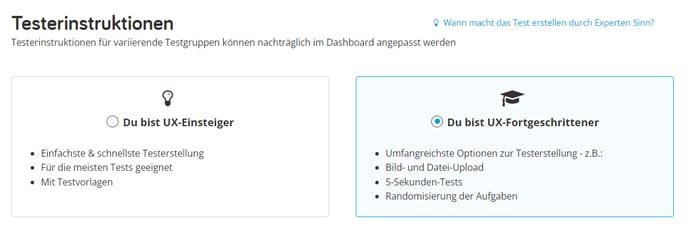

1. Wähle bei der Erstellung deines Usability-Tests die Experten-Features aus:

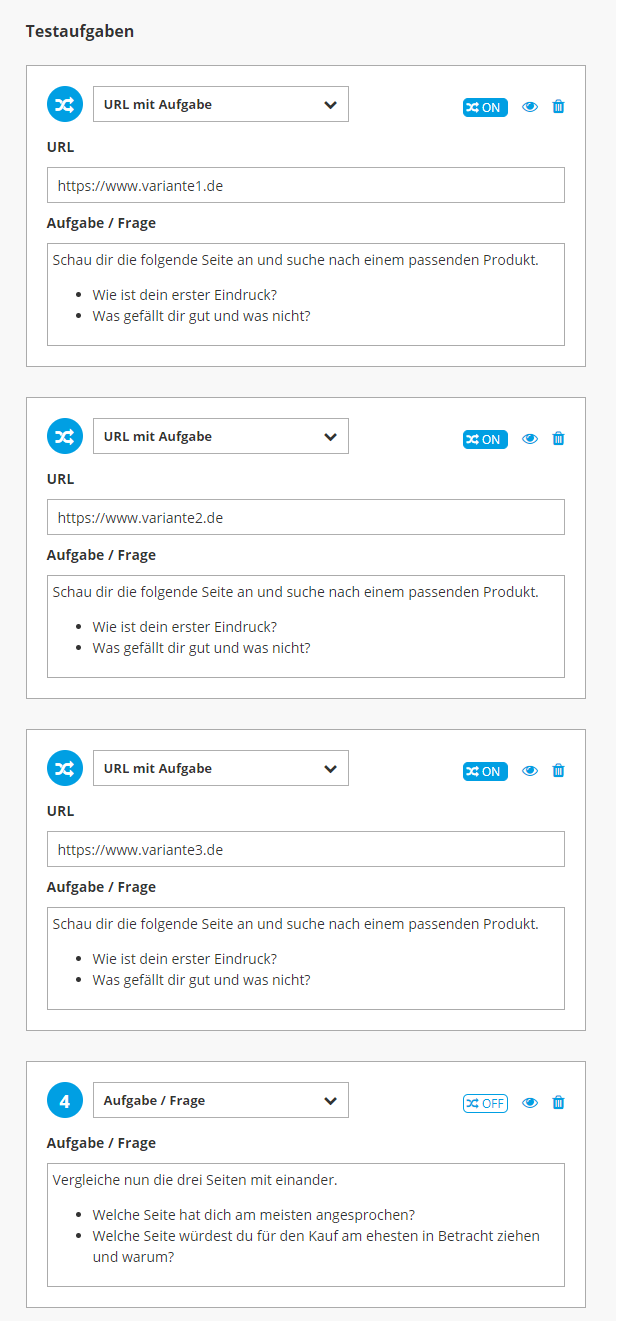

2. Formuliere für jede Variante eine Aufgabe und wähle bei den zufällig anzuzeigenden Aufgaben die Randomisierungsoption:

Im Screenshot siehst du außerdem ein Beispiel für ein mögliches Testkonzept.

3. Innerhalb der Videos kannst du nachvollziehen, in welcher Reihenfolge jedem Tester die Aufgaben angezeigt wurden:

Das musst du bei der Erstellung von Vergleichstests beachten

-

Maximal 3 Varianten: Wir empfehlen dir maximal drei Aufgaben zu randomisieren, also maximal drei Varianten zu testen. Mehr Auswahlmöglichkeiten könnten die Tester überfordern, vor allem wenn du am Ende von den Testern eine Entscheidung für eine der Varianten erwartest.

-

Maximal 20 Minuten: Achte darauf, dass dein Test nicht länger als 20 Minuten dauern sollte. Alternativ kannst du den Test „Between-Group“ (s.o.) testen oder wir berechnen dir einen Überlängezuschlag (für mehr Infos kontaktiere uns unter 030 555 747 987, per Mail oder unten im Chat).

-

Mindestens 10 Teilnehmer: Um valide Ergebnisse zu erhalten und die Erkenntnisse priorisieren zu können, solltest du Vergleichstests mit mindestens 10 Testern durchführen.

-

Keine aufeinander aufbauenden Aufgaben: Achte darauf, dass deine randomisierten Aufgaben nicht aufeinander aufbauen. Sollen die Tester je Variante ganze User Journeys durchlaufen, kannst du dies nicht in einem einzigen Test abfragen. Erstelle in diesem Fall für jede Variante einen eigenen Test.

Aufgabenrandomisierung sind Teil von RapidUsertests Premium

RapidUsertests Premium ist unser neues All-in-One-Tool für UX-Testing und -Research:

- Bessere Kollaboration durch UX-Repository, Transkription und Übersetzung der Videos

- Effizientere Research durch Methoden wie Adhoc-Tests, 5-Minuten-Tests und Inhouse-Tests

- Tiefere Insights mit dem UX-Lab in der Cloud

- Mehr Impact im Unternehmen, z.B. durch Highlight-Videos und Team-Schulungen

Hast du Interesse an eine kostenlosen und unverbindlichen Demo? Dann vereinbare hier einen Termin.

-3.png)